PROCESAMIENTO DE IMÁGENES DIGITALES

"Imagen monocromática" simplemente, se refiere a una función de intensidad de luz bidimensional f(x,y). "X" e "Y" indican las coordenadas espaciales y el valor de f en cualquier punto (x,y) es proporcional a la luminosidad (o nivel de gris) de la imagen en dicho punto.

una imagen digital es una imagen (función) f(x,y) que ha sido discretizada tanto en coordenadas espaciales como en luminosidad.

una imagen digital puede ser considerada una matriz cuyos indices de renglón y columna identifican un punto (un lugar en el espacio bidimensional) en la imagen y el correspondiente valor de elemento de matriz identifica el nivel de gris en aquel punto.Los elementos de estos arreglos digitales son llamados elementos de imagen o pixels.

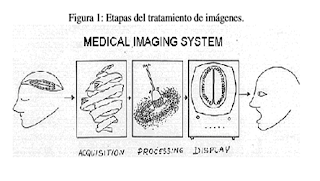

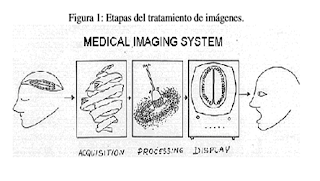

En el tratamiento de imágenes se pueden distinguir tres etapas principales:

1.- Adquisición de la imagen.

2.- Procesamiento de la imagen.

3.- Presentación al observador.

La adquisición de la imagen está a cargo de algún transductor o conjunto de transductores que mediante la manipulación de la luz o de alguna otra forma de radiación que es emitida o reflejada por los cuerpos, se logra formar una representación del objeto dando lugar a la imagen. Ejemplos: el ojo humano, sensores de una cámara fotográfica o de vídeo, tomógrafos.

Durante La Etapa De Adquisición, los transductores agregan ruido a la imagen.

Además del ruido, los transductores poseen una resolución limitada, lo cual repercute en la apreciación de dicha imagen .

El Procesamiento Digital de la imagen consiste en eliminar la mayor cantidad de ruido que se le agrega durante la adquisición así como también mejorar las características de dicha imagen como:

definición de contornos, color, brillo, etc., valiéndose de procedimientos y herramientas matemáticas.

En esta etapa se encuentran también técnicas de codificación para el almacenamiento o bien para la transmisión.

La Presentación Al Observador

Para la presentación de la imagen se deben considerar ciertos aspectos de percepción humana así como las velocidades de despliegue del dispositivo utilizado.

Para la selección del procesamiento y/o codificación que se hará sobre una señal, es necesaria una interpretación de las componentes de la señal. El modelo del sistema de visión humano puede ser utilizado en ciertas etapas de procesamiento para dicha interpretación.

Los Dispositivos de Despliegue: sintetizan una imagen usando un número finito de respuestas básicas de despliegue, como los puntos de fósforo utilizados en un tubo de rayos catódicos.

*Seleccionar el tamaño

*La Forma

*La Configuración (Número Y Posición Relativa)

*Obtener Imágenes Con La Calidad/Fidelidad

*Controlados De La Mejor Manera Óptima

Realizar un breve estudio, sobre el funcionamiento del sistema visual humano (Human Visual System, HVS) Será de utilidad para entender mejor la forma en que percibimos las imágenes y con ello, poder explotar estas características en el tratamiento digital de imágenes.

Es posible modelar el ojo humano como un sistema lineal e invariante en el tiempo (SLI). Para ello se deben tener presentes dos conceptos:

* La Respuesta Al Impulso

* La Función De Transferencia

La Respuesta Al Impulso, que es una función que describe el comportamiento en el tiempo de un sistema,

La Función De Transferencia

Describe al sistema en el dominio de la frecuencia, y es la transformada de Fourier de la respuesta impulso.

El ojo se puede modelar como un sistema que modifica funciones y que depende de tres variables. La respuesta puede ser representada como una función que también depende de tres variables (dos espaciales y una temporal).

Un filtro

paso-bajas, cuya frecuencia de corte se ubicaba en el intervalo de 24 a 30 imágenes por segundo.Efecto conocido como flicker, frecuencia del ojo puede variar, según la intensidad de la luz. En las pantallas de cristal líquido (LCD, Liquid CrystalDisplay), los cristales de un mismo color se colocaban en líneas verticales, lo que daba como resultado una resolución desagradable a la vista del observador; Esto motivó a los investigadores a buscar una solución que mejorara la calidad de la imagen.

1.Disminuir el tamaño de los cristales de tal forma que la resolución aumentara .

2. cambiar la disposición de los cristales de forma que en lugar de formar líneas verticales formaran líneas diagonales

Las líneas de LCD al ser diagonales, también construyen pequeños hexágonos que permiten tener una mejor adaptación a las células receptoras del ojo.

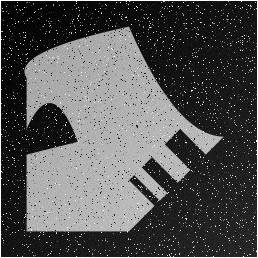

El ruido en las imágenes se manifiesta como un aumento en la brillantez de algunos pixels más que en otros es un problema común y complicado de resolver. El ruido existe, tanto en frecuencias altas como bajas, y la imagen sólo tiene valores significativos de amplitud en frecuencias bajas, una forma de suprimir el ruido de la imagen es aplicándole un filtro paso-bajas,

A esta resta se le llama error de estimación, y se puede observar que el error de estimación es menor en la imagen tratada, que en la imagen que contiene ruido .El error de estimación se espera que sea el mínimo entre una imagen nítida y una imagen filtrada .Sin embargo es interesante observar que si la imagen contiene poco ruido, los observadores preferirán las imágenes con ruido, que las imágenes que han sido filtradas.

El ojo humano es más tolerante con el ruido que contra la falta de nitidez. Sólo cuando hay demasiado ruido es preferible, para el ojo humano, una imagen filtrada.

Factor más importante en la presentación de una imagen es la nitidez.

Podemos constatar entonces que el ojo tiene sólo cierta tolerancia al ruido.

El ojo también tiene limitaciones en la resolución espacial, y muestra de ello es el siguiente ejemplo: Cuando se ve de cerca la pintura de Salvador Dalí

Las áreas de aplicación del tratamiento de imágenes digitales son muchas, siendo la Medicina, Astronomía, Micros-copia, entre otras tantas disciplinas, las beneficiarias del Procesamiento Digital de Imágenes.

Además existen diversos modelos para la formación de imágenes y la utilización de estos depende de lo que se desea estudiar . por ejemplo las imágenes acústicas; en donde se utilizan sonidos tanto en frecuencias bajas (usados en Geología) como de ultrasonido comúnmente usadas en medicina.

VISIÓN POR COMPUTADORA

¿Qué es Visión?

Visión es la ventana al mundo de muchos organismos. Su función principal es reconocer y localizar objetos en el ambiente mediante el procesamiento de las imágenes. La visión computacional es el estudio de estos procesos, para entenderlos y construir máquinas con capacidades similares.

Existen varias definiciones de visión, entre éstas podemos mencionar las siguientes:

Visión es saber que hay y dónde mediante la vista“, (Aristóteles).

Visión es recuperar de la información de los sentidos (vista) propiedades válidas del mundo exterior", Gibson.

Visión es un proceso que produce a partir de las imágenes del mundo exterior una descripción que es útil para el observador y que no tiene información irrelevante", Marr.

Un área muy ligada a la de visión computacional es la de procesamiento de imágenes. Aunque ambos campos tienen mucho en común, el objetivo final es diferente. El objetivo de procesamiento de imágenes es mejorar la calidad de las imágenes para su posterior utilización o interpretación, por ejemplo:

ü Remover defectos.

ü Remover problemas por movimiento o desenfoque.

ü Mejorar ciertas propiedades como color, contraste, estructura, etc.

ü Agregar “colores falsos” a imágenes monocromáticas.

Esquema general del procesamiento de imágenes.

Esquema general de visión por computadora.

En la siguiente figura se muestra un ejemplo de procesamiento de imágenes. La tarea a realizar es mejorar la imagen de entrada, la cual es obscura. La imagen de salida es esencialmente la misma pero de mejor calidad o “más útil".

La figura mostrada a continuación ilustra la diferencia entre procesamiento de imágenesy visión; nótese que la imagen muestra ciertas descripciones importantes, como los números, que previamente fueron detectados. La salida de este sistema de visión se complementa con un módulo de reconocimiento de patrones, es decir, “saber" que letras y números contiene la placa.

Actualmente existen múltiples aplicaciones practicas de la visión computacional, entre estas podemos mencionar las siguientes:

v Robótica móvil y vehículos autónomos.

v Manufactura.

v Interpretación de imágenes aéreas y de satélite.

v Análisis e interpretación de imágenes medicas.

v Análisis de imágenes para astrónoma.

Formación y representación de la imagen.

La formación de la imagen ocurre cuando un sensor (ojo, cámara) registra la radiación (luz) que ha interactuado con ciertos objetos físicos, como se muestra en la figura 5. La imagen obtenida por el sensor se puede ver como una función bidimensional, donde el valor de la función corresponde a la intensidad o brillantez en cada punto de la imagen (imágenes monocromáticas, conocidas como imágenes en “blanco y negro"). Generalmente, se asocia un sistema coordenado (x; y) a la imagen, con el origen en el extremo superior izquierdo, ver figura 6.

Una función de la imagen es una representación matemática de la imagen. Esta es generalmente una función de dos variables espaciales (x; y):

I = f(x; y) (1.1)

Donde f representa el nivel de brillantez o intensidad de la imagen en las coordenadas (x; y). Si representamos estas funciones gráficamente, se tienen 3 dimensiones: dos que corresponden a las coordenadas de la imagen y la tercera a la función de intensidad, (figura 7).

Una imagen multiespectral f es una función vectorial con componentes (f1; f2; …, fn), donde cada una representa la intensidad de la imagen a diferentes longitudes de onda. Por ejemplo, una imagen a color generalmente se representa por la brillantez en tres diferentes longitudes de onda:

Una imagen digital es una imagen que ha sido discretizada tanto en valor de intensidad (f) como especialmente, es decir que se ha realizado un muestreo de la función continua. Este muestreo se representa matemáticamente mediante la multiplicación de la función con un arreglo bidimensional de funciones delta:

Donde cada valor de intensidad, fs(x; y), es mapeado o discretizado a un numero, por ejemplo un numero entre 0 y 255. Entonces una imagen digital monocromática puede ser representada por una matriz de NxM, donde cada valor es un numero que representa el nivel de intensidad del punto correspondiente de la imagen. Cada punto se conoce como pixel (del ingles, picture element).

Dispositivos para Visión

Existe diferentes dispositivos para la captura de imágenes. Dichas imágenes son digitalizadas y almacenadas en la memoria de la computadora. Una vez en la computadora, o en ocasiones desde el mismo dispositivo de captura, la imagen puede ser ya procesada.

Para la adquisición de la imagen se requiere de un dispositivo físico que sea sensible a una determinada banda del espectro electromagnético. El dispositivo produce una señal eléctrica proporcional al nivel de energía detectado, la cual es posteriormente digitalizada. Entre los dispositivos de captura o sensores se encuentran:

Cámaras fotográficas.

Cámaras de televisión (vidicón o de estado solido - CCD).

Digitalizadores (scanners).

Sensores de rango (franjas de luz, laser).

Sensores de ultrasonido (sonares).

Rayos X.

Imágenes de tomografía.

Imágenes de resonancia magnética.

ANIMACIÓN POR COMPUTADORA

¿QUÉ ES LA ANIMACIÓN POR COMPUTADORA?

La animación por computadora es el arte de crear imágenes en movimiento mediante el uso de computadoras.

Cada vez más los gráficos creados son en 3D, aunque los gráficos en 2D todavía se siguen usando ampliamente para conexiones lentas y aplicaciones en tiempo real que necesitan renderizar rápido.

Para crear la ilusión del movimiento, una imágen se muestra en pantalla sustituyéndose rápidamente por una nueva imágen en un fotograma diferente. Esta técnica es idéntica ala manera en que se logra la ilusión del movimiento en las películas y en la televisión.

Para crear una cara en 3D se modela el cuerpo, ojos, boca, etc.Del personaje posteriormente se animan con controladores de animación.

En la mayor parte de los sistemas de animación en 3D,un animador crea una representación simplificada del cuerpo del personaje, análogo a un esqueleto o stick figure. La posición de cada segmento del modelo del esqueleto definida por <<variables de la animación>>.

EXPLICACIÓN

Para engañar al ojo y al cerebro para que alguien piense que está viendo un objeto en movimiento, las imágenes deben ser mostradas a alrededor de 12 imágenes o marcos por segundo o más rápido. Con velocidades superiores a los 70 frames/segundo, no se notará una mejoría en el realismo o suavidad en el movimiento de la imágen debido ala manera en que el ojo y el cerebro procesan las imágenes. A velocidades menores a 12 frames/segundo la mayoría de las personas podrán detectar un parpadeo en el momento en que se muestren las secuencia de imágenes y disminuirá la ilusión de un movimiento realista.

El motivo de que a altas velocidades no sea perceptible el parpadeo de la imágen, es por la <<persistencia de la visión>>. De momento a momento, el ojo y cerebro trabajando juntos almacenan cualquier cosa que se esté mirando por una fracción por segundo, y automáticamente realiza <<saltos>> pequeños y suaves. Las películas que se exhiben en los cines, corren a 24 frames/segundo, que es suficiente para crear esta ilusión de movimiento continuo.

Bibliografias

1] Gonzalez, R. C. , and Woods, P., Digital Image Processing, Addison Wesley, 2002

[2]http://encyclopedia.thefreedictionary.com/light

[3] Hecht, E.,Óptica, Addison Wesley Iberoamericana, Madrid, 2000

http://verona.fi-p.unam.mx/boris/teachingnotes/Introduccion.pdf

No hay comentarios:

Publicar un comentario